https://karpathy.bearblog.dev/year-in-review-2025/

2025 LLM Year in Review

2025 Year in Review of LLM paradigm changes

karpathy.bearblog.dev

위 글 말고도 카파시의 생각을 읽을 수 있는 블로그. 다양한 주제가 많음.

위 카파시의 글 읽고 생각메모

+ 영어 공부

+ 릴리스 요약노트 및 인포그래픽

* 영어 공부

- 'Gobbled up'은 '허겁지겁 먹어치우다, 게걸스럽게 먹다, 꿀꺽 삼키다'라는 뜻으로, 마치 칠면조가 목에서 '골골' 소리를 내며 음식을 급하게 삼키는 모습에서 유래된 표현입니다. 단순히 먹다(eat)를 넘어, 매우 빠르고 욕심스럽게, 혹은 완전히 없애버리듯이 먹는 상황을 강조할 때 사용

- point of inflection : 변곡점

- vicinity : 부근

As verifiable domains allow for RLVR, LLMs "spike" in capability in the vicinity of these domains

- polymath 박식가

- jailbreak 탈옥 / exfiltrate : 유출

seconds away from getting tricked by a jailbreak to exfiltrate your data.

- grow jaggies : 들쭉날쭉하게 자라다.

- i coined the term : 내가 그 용어를 만들었다

* Byte-Pair Encoding (BPE) 토크나이저.

* TL;DR은 "Too Long; Didn't Read"의 줄임말로, '너무 길어서 읽지 않았다'는 뜻이며, 주로 긴 글의 핵심 요약본을 제공하거나, 요약을 요청할 때 사용하는 인터넷 신조어입니다. 본문 앞에 붙여 요약이 시작됨을 알리거나, 본문의 마지막에 요약을 덧붙이는 방식으로 사용됩니다

* sycophancy. 아첨!

2025년 LLM 분야의 패러다임 변화를 꿰뚫어 보는 핵심 인사이트가 담긴 연말 결산입니다. 이 콘텐츠는 기존의 RLHF를 넘어선 RLVR(검증 가능한 보상 기반 강화 학습)의 등장과 LLM 지능의 '유령(Ghosts) vs. 동물(Animals)' 비유를 통해, 벤치마크에 대한 신뢰 하락과 '재그드 인텔리전스(Jagged Intelligence)'의 특성을 명확히 이해하도록 돕습니다. 특히, '바이브 코딩(Vibe Coding)'과 'LLM GUI'의 등장을 통해 앞으로 소프트웨어 개발과 사용자 인터페이스가 어떻게 근본적으로 변화할지 구체적인 적용 방향을 제시합니다.

2025 LLM 연말 결산: 패러다임 변화와 새로운 지능의 형태

이 문서는 2025년 LLM 분야에서 나타난 개인적으로 주목할 만하고 놀라운 패러다임 변화들을 시간 순서대로 정리한 타임라인 노트입니다.

1. RLVR(검증 가능한 보상 기반 강화 학습)의 등장

2025년, LLM 훈련 스택에 RLVR(Reinforcement Learning from Verifiable Rewards)이라는 새로운 주요 단계가 추가되었습니다.

- 2025년 초반의 표준 LLM 훈련 스택:

- 사전 훈련 (Pretraining): 2020년경의 GPT-2/3 수준

- 지도 미세 조정 (Supervised Finetuning, SFT): 2022년경의 InstructGPT 수준

- 인간 피드백 기반 강화 학습 (RLHF): 2022년경의 기술

- 이 조합은 한동안 프로덕션급 LLM 훈련을 위한 안정적이고 검증된 방식이었습니다.

- RLVR의 도입과 영향:

- RLVR은 LLM 훈련 스택에 추가된 새로운 주요 단계입니다.

- LLM은 수학/코드 퍼즐과 같은 여러 환경에서 자동으로 검증 가능한 보상을 기반으로 훈련됩니다.

- 이 훈련을 통해 LLM은 인간에게 "추론"처럼 보이는 전략을 자발적으로 개발합니다.

- 문제를 중간 계산으로 나누는 방법을 학습합니다.

- 앞뒤로 오가며 문제를 해결하기 위한 다양한 문제 해결 전략을 학습합니다. (예: DeepSeek R1 논문 참조)

- 이러한 전략은 이전 패러다임에서는 달성하기 어려웠는데, 최적의 추론 경로와 복구 과정이 무엇인지 불분명했기 때문입니다. LLM은 보상 최적화를 통해 스스로 작동하는 방식을 찾아야 했습니다.

- SFT 및 RLHF 단계와 달리, RLVR은 객관적이고 조작 불가능한(non-gameable) 보상 함수를 대상으로 하므로 훨씬 더 긴 최적화 훈련이 가능합니다.

- RLVR 실행은 높은 성능 대비 비용 효율성($/$)을 제공했으며, 이로 인해 원래 사전 훈련에 사용될 예정이었던 컴퓨팅 자원을 소모했습니다.

- 결과적으로 2025년 성능 향상의 대부분은 이 새로운 단계를 소화하는 과정에서 발생했으며, LLM 크기는 비슷했지만 RL 훈련 시간이 훨씬 길어졌습니다.

- 새로운 제어 변수의 발견:

- RLVR 단계의 고유한 특징으로, 추론 추적(reasoning traces)을 길게 생성하고 "사고 시간(thinking time)"을 늘림으로써 테스트 시점 컴퓨팅에 따른 성능을 제어할 수 있는 새로운 조절 변수(컨트롤 장치)와 관련 스케일링 법칙이 발견되었습니다.

- RLVR 모델의 분기점:

- OpenAI의 o1 모델(2024년 말)이 RLVR 모델의 첫 시연이었지만, o3 릴리스(2025년 초)가 그 차이를 직관적으로 느낄 수 있는 명확한 분기점이었습니다.

2. 유령(Ghosts) vs. 동물(Animals) / 들쭉날쭉한 지능(Jagged Intelligence)

2025년은 LLM 지능의 "형태"를 더 직관적으로 이해하기 시작한 해입니다.

- 지능에 대한 새로운 인식:

- 우리는 "동물을 진화/성장"시키는 것이 아니라, "유령을 소환"하고 있습니다.

- 신경 아키텍처, 훈련 데이터, 알고리즘, 최적화 압력 등 LLM 스택의 모든 것이 다르기 때문에, 동물의 렌즈로 이들을 이해하는 것은 부적절합니다.

- 인간 신경망은 부족의 생존을 위해 최적화된 반면, LLM 신경망은 인류의 텍스트를 모방하고, 수학 퍼즐에서 보상을 수집하며, LM 아레나에서 인간의 업보트(upvote)를 받는 데 최적화되어 있습니다.

- 들쭉날쭉한 성능 특성:

- RLVR이 검증 가능한 영역에서 가능해지면서, LLM은 해당 영역 근처에서 성능이 급격히 "치솟는(spike)" 현상을 보이며 전반적으로 우스꽝스러울 정도로 들쭉날쭉한(jagged) 성능 특성을 나타냅니다.

- 이들은 동시에 천재적인 박식가이면서도, 탈옥(jailbreak)에 속아 데이터를 유출할 수 있는 인지적으로 장애가 있는 초등학생과 같습니다.

- 인간 지능 역시 다른 방식으로 들쭉날쭉하다는 점을 지적하는 밈 버전이 존재합니다.

- 벤치마크에 대한 신뢰 하락:

- 벤치마크는 본질적으로 검증 가능한 환경이므로 RLVR이나 그 약한 형태(합성 데이터 생성)에 즉시 취약해집니다.

- LLM 연구소의 팀들은 벤치마크가 차지하는 임베딩 공간의 작은 영역 근처에 환경을 구성하고 이를 덮도록 들쭉날쭉한 성능을 성장시키는 과정(벤치마크 조작)을 피할 수 없습니다.

- 테스트 세트로 훈련하는 것이 2025년의 새로운 예술 형태가 되었습니다.

- 추가 논의 주제:

- 모든 벤치마크를 압도하면서도 AGI에 도달하지 못하는 현상에 대해 더 많은 논의가 있었습니다.

- 이 섹션의 주제(동물 대 유령, 검증 가능성, 마음의 공간)에 대해 더 자세히 작성된 글이 있습니다.

3. 커서(Cursor) / LLM 앱의 새로운 계층

Cursor의 눈에 띄는 점은 "LLM 앱"의 새로운 계층을 설득력 있게 보여주었다는 것입니다.

- LLM 앱의 구성 요소:

- LLM 앱은 특정 수직 분야를 위해 LLM 호출을 묶고 오케스트레이션합니다.

- 컨텍스트 엔지니어링(context engineering)을 수행합니다.

- 성능과 비용의 균형을 맞추기 위해 점점 더 복잡한 DAG(Directed Acyclic Graph)로 엮인 여러 LLM 호출을 내부적으로 오케스트레이션합니다.

- 인간이 개입할 수 있는 애플리케이션별 GUI를 제공합니다.

- "자율성 슬라이더(autonomy slider)"를 제공합니다.

- 새로운 앱 계층의 두께에 대한 논의:

- 2025년에는 이 새로운 앱 계층이 얼마나 "두꺼울지(thick)"에 대한 많은 논의가 있었습니다.

- LLM 연구소들이 모든 애플리케이션을 장악할지, 아니면 LLM 앱을 위한 새로운 기회의 땅이 있을지에 대한 질문이 제기되었습니다.

- 개인적인 견해로는, LLM 연구소는 일반적으로 유능한 대학생 수준을 배출하는 경향이 있지만, LLM 앱은 개인 데이터, 센서, 액추에이터 및 피드백 루프를 제공하여 이들을 특정 분야의 배포된 전문가 팀으로 조직하고 미세 조정하며 실제로 움직이게 할 것이라고 추측합니다.

4. 클로드 코드(Claude Code) / 컴퓨터에 상주하는 AI

Claude Code(CC)는 LLM 에이전트의 첫 번째 설득력 있는 시연으로 등장했습니다.

- LLM 에이전트의 특징:

- CC는 도구 사용과 추론을 루프 방식으로 엮어 장기간의 문제 해결을 수행하는 LLM 에이전트의 모습을 보여주었습니다.

- 로컬 실행의 중요성:

- CC는 사용자의 컴퓨터에서 개인 환경, 데이터 및 컨텍스트를 가지고 실행된다는 점에서 주목할 만합니다.

- OpenAI는 초기 Codex/에이전트 노력을 챗GPT에서 오케스트레이션되는 클라우드 배포에 집중했기 때문에 이 부분을 잘못 이해했다고 봅니다.

- 클라우드에서 실행되는 에이전트 군집이 "AGI 종말(endgame)"처럼 보일 수 있지만, 현재는 들쭉날쭉한 능력을 가진 중간적이고 느린 이륙(slow takeoff) 세계이므로 에이전트를 개발자의 컴퓨터에서 직접 실행하는 것이 더 합리적입니다.

- 중요한 구분점은 "AI 운영(AI ops)"이 클라우드나 로컬에서 실행되는지가 아니라, 이미 부팅된 컴퓨터, 설치, 컨텍스트, 데이터, 비밀 정보, 구성 및 저지연 상호 작용과 같은 나머지 모든 요소에 있습니다.

- Anthropic은 이러한 우선순위를 올바르게 파악하고 CC를 최소한의 CLI 형태로 패키징하여 AI의 모습을 변화시켰습니다. AI는 구글처럼 방문하는 웹사이트가 아니라, 컴퓨터에 "사는" 작은 영혼/유령이 되었습니다.

- 이는 AI와 상호작용하는 새롭고 뚜렷한 패러다임입니다.

5. 바이브 코딩(Vibe coding)

2025년은 AI가 영어를 통해 인상적인 프로그램을 구축할 수 있는 능력의 임계점을 넘어선 해입니다.

- 바이브 코딩의 정의와 영향:

- 바이브 코딩은 프로그래밍이 고도로 훈련된 전문가에게만 국한되는 것이 아니라 누구나 할 수 있는 일이 되게 합니다.

- 이는 LLM이 다른 모든 기술과 달리 일반 대중에게 전문가, 기업, 정부보다 훨씬 더 많은 이점을 제공한다는 "Power to the people"에서 언급한 기술 확산의 역전 현상의 또 다른 예시입니다.

- 바이브 코딩은 일반 대중에게 프로그래밍을 가능하게 할 뿐만 아니라, 훈련된 전문가들이 그렇지 않았다면 작성되지 않았을 훨씬 더 많은 (바이브 코딩된) 소프트웨어를 작성하도록 역량을 강화합니다.

- 바이브 코딩의 실제 적용 사례:

- 필자는 nanochat에서 기존 라이브러리를 채택하거나 Rust를 해당 수준까지 배울 필요 없이 Rust로 자체적인 고효율 BPE 토크나이저를 바이브 코딩했습니다.

- 존재하기를 원했던 것의 빠른 앱 데모(예: menugen, llm-council, reader3, HN time capsule)를 위해 올해 많은 프로젝트를 바이브 코딩했습니다.

- 코드가 갑자기 무료, 일시적, 가변적, 단일 사용 후 폐기 가능해졌기 때문에 단 하나의 버그를 찾기 위해서도 전체 임시 앱을 바이브 코딩했습니다.

- 미래 전망:

- 바이브 코딩은 소프트웨어를 변형시키고 직무 설명을 바꿀 것입니다.

6. 나노 바나나(Nano banana) / LLM GUI

Google Gemini Nano banana는 2025년의 가장 놀랍고 패러다임을 전환하는 모델 중 하나입니다.

- LLM 컴퓨팅 패러다임의 진화:

- LLM은 1970~80년대 컴퓨터와 유사한 다음 주요 컴퓨팅 패러다임으로 부상하고 있습니다.

- 이로 인해 개인용 컴퓨팅, 마이크로컨트롤러(인지 코어), 인터넷(에이전트의 인터넷) 등의 유사한 혁신이 유사한 근본적인 이유로 나타날 것입니다.

- UI/UX의 변화 필요성:

- UI/UX 측면에서 LLM과의 "채팅"은 1980년대 컴퓨터 콘솔에 명령을 내리는 것과 유사합니다.

- 텍스트는 컴퓨터(및 LLM)의 기본/선호 데이터 표현이지만, 사람들에게는 선호되는 형식이 아닙니다. 특히 입력에서 그렇습니다.

- 사람들은 텍스트를 읽는 것을 싫어하며, 시각적이고 공간적으로 정보를 소비하는 것을 선호하기 때문에 전통적인 컴퓨팅에서 GUI가 발명되었습니다.

- 마찬가지로 LLM도 이미지, 인포그래픽, 슬라이드, 화이트보드, 애니메이션/비디오, 웹 앱 등 사람이 선호하는 형식으로 소통해야 합니다.

- LLM GUI의 초기 형태와 잠재력:

- 이 변화의 초기 및 현재 버전은 이모티콘과 마크다운으로, 제목, 굵게, 기울임꼴, 목록, 표 등을 사용하여 텍스트를 시각적으로 쉽게 소비할 수 있도록 "꾸미고" 배치하는 방식입니다.

- 질문은 누가 LLM GUI를 구축할 것인가입니다.

- Nano banana는 그 모습이 어떠할지에 대한 첫 번째 초기 힌트를 제공합니다.

- 중요한 점은 이것이 이미지 생성 자체에만 국한된 것이 아니라, 텍스트 생성, 이미지 생성, 세계 지식이 모델 가중치 내에 얽혀서 나오는 결합된 능력에 관한 것이라는 점입니다.

7. 2025년 총평 및 향후 전망

- 2025년 요약:

- 2025년은 LLM에 있어 흥미롭고 다소 놀라운 한 해였습니다.

- LLM은 예상보다 훨씬 똑똑하고, 예상보다 훨씬 멍청한 새로운 종류의 지능으로 부상하고 있습니다.

- 어떤 경우든 LLM은 매우 유용하며, 현재 능력 수준에서도 업계가 잠재력의 10%도 실현하지 못했다고 생각합니다.

- 시도해 볼 아이디어가 많으며 개념적으로 분야는 완전히 열려 있습니다.

- 향후 전망:

- 올해 초 Dwarkesh 팟캐스트에서 언급했듯이, 빠르고 지속적인 발전이 있을 것이라고 믿는 동시에 아직 해야 할 일이 많다고 동시에 믿습니다.

- 대비해야 합니다.

아래는 번역본 via Google Translation

2025년은 LLM 분야에서 눈에 띄고 의미 있는 발전이 이루어진 한 해였습니다. 개인적으로 주목할 만하고 다소 놀라웠던 "패러다임 변화"들을 아래에 정리해 보았습니다. 이러한 변화들은 LLM 업계의 지형을 바꾸고 개념적으로 제게 깊은 인상을 남겼습니다.

1. 검증 가능한 보상 기반 강화 학습(RLVR)

2025년 초, 모든 연구소의 LLM 운영 스택은 다음과 같았습니다.

사전 학습(GPT-2/3, ~2020년)

지도 미세 조정(InstructGPT, ~2022년)

인간 피드백 기반 강화 학습(RLHF, ~2022년)

이러한 방식은 오랫동안 상용 LLM을 학습시키는 안정적이고 검증된 방법이었습니다. 2025년, 검증 가능한 보상 기반 강화 학습(RLVR)이 이러한 스택에 새롭게 추가되는 핵심 기술로 부상했습니다. LLM(학습 모델)은 다양한 환경(예: 수학/코드 퍼즐)에서 자동으로 검증 가능한 보상을 사용하여 학습함으로써 인간의 "추론"과 유사한 전략을 자발적으로 개발합니다. 즉, 문제 해결 과정을 중간 계산으로 분해하고, 문제를 해결하기 위해 여러 단계를 반복하는 다양한 전략을 학습합니다(예는 DeepSeek R1 논문 참조). 이러한 전략은 이전 패러다임에서는 달성하기 매우 어려웠습니다. 최적의 추론 경로와 복구 과정이 명확하지 않았기 때문입니다. LLM은 보상에 대한 최적화를 통해 자신에게 맞는 방식을 찾아야 했습니다.

SFT(스위칭 함수 이론) 및 RLHF(역추적 함수 이론) 단계는 비교적 짧고 간단한 단계(사소한 계산 미세 조정)인 반면, RLVR(역추적 보상 함수 이론)은 객관적인(조작 불가능한) 보상 함수를 사용하여 학습하므로 훨씬 더 긴 최적화 과정이 필요합니다. RLVR을 실행한 결과 높은 성능 대비 비용을 보여주었으며, 이로 인해 원래 사전 학습에 할당되었던 컴퓨팅 자원이 모두 소모되었습니다. 따라서 2025년의 역량 발전은 대부분 LLM 연구소들이 이 새로운 단계의 난관을 극복하는 데서 비롯되었으며, 전반적으로 LLM의 규모는 비슷했지만 RL 실행 시간은 훨씬 길어졌습니다. 또한 이 새로운 단계에서는 추론 과정을 더 길게 만들고 "사고 시간"을 늘림으로써 테스트 시간 계산량에 따라 역량을 제어할 수 있는 완전히 새로운 조절 장치(및 관련 스케일링 법칙)가 생겼습니다. OpenAI o1(2024년 말)은 RLVR 모델을 최초로 시연한 사례였지만, o3(2025년 초)은 그 차이를 직관적으로 느낄 수 있는 명확한 변곡점이었습니다.

2. 유령 vs. 동물 / 불규칙한 지능

2025년은 저를 비롯한 업계 전체가 LLM 지능의 "형태"를 보다 직관적으로 이해하기 시작한 시점입니다. 우리는 "진화/성장하는 동물"이 아니라 "유령을 소환"하는 것입니다. LLM 스택의 모든 것이 다릅니다(신경망 아키텍처, 훈련 데이터, 훈련 알고리즘, 특히 최적화 압력). 따라서 지능 영역에서 매우 다른 개체들이 나타나는 것은 당연한 일이며, 이러한 개체를 동물의 관점에서 생각하는 것은 적절하지 않습니다. 지도 학습 측면에서 인간의 신경망은 정글 부족의 생존에 최적화되어 있는 반면, LLM 신경망은 인간의 텍스트를 모방하고, 수학 퍼즐에서 보상을 획득하고, LM Arena에서 인간에게 추천을 받는 데 최적화되어 있습니다. 검증 가능한 영역에서 RLVR이 가능해짐에 따라 LLM은 이러한 영역 근처에서 능력이 급증하고 전반적으로 들쭉날쭉한 성능 특성을 보입니다. 마치 천재적인 박식가이면서 동시에 혼란스럽고 인지 능력이 부족한 초등학생처럼, 탈옥에 속아 데이터를 유출당하기 직전의 상태와 같습니다.

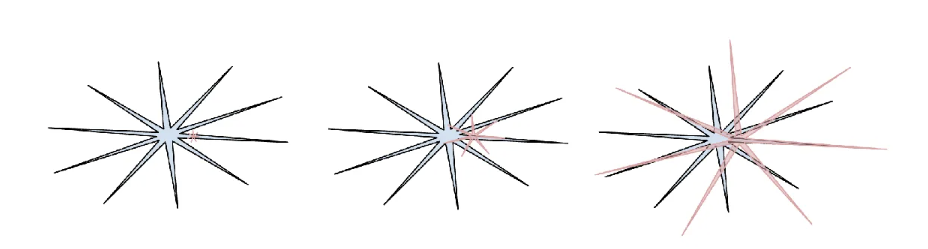

G6zymj4a0AMNJkJ(인간 지능: 파란색, AI 지능: 빨간색. 이 밈의 버전이 마음에 듭니다. (원래 게시물 링크를 잃어버려서 죄송합니다.) 인간 지능도 나름대로 들쭉날쭉하다는 점을 잘 보여주기 때문입니다.)

이 모든 것과 관련하여, 저는 2025년에도 벤치마크에 대한 무관심과 불신을 느끼고 있습니다. 핵심 문제는 벤치마크가 본질적으로 검증 가능한 환경이라는 점이며, 따라서 합성 데이터 생성을 통해 RLVR 및 그보다 약한 형태의 기법에 즉시 취약하다는 것입니다. 일반적인 벤치마크 최적화 과정에서 LLM 연구소의 팀들은 벤치마크가 차지하는 임베딩 공간의 작은 영역에 인접한 환경을 구축하고, 그 영역을 덮기 위해 들쭉날쭉한 형태를 만들어냅니다. 테스트 세트 학습은 새로운 예술 형식이 되었습니다.

모든 벤치마크를 뛰어넘으면서도 AGI를 달성하지 못하는 것은 어떤 모습일까요?

이 주제에 대해 더 자세히 다룬 글은 여기에서 볼 수 있습니다.

동물 vs. 유령

검증 가능성

마음의 공간

댓글